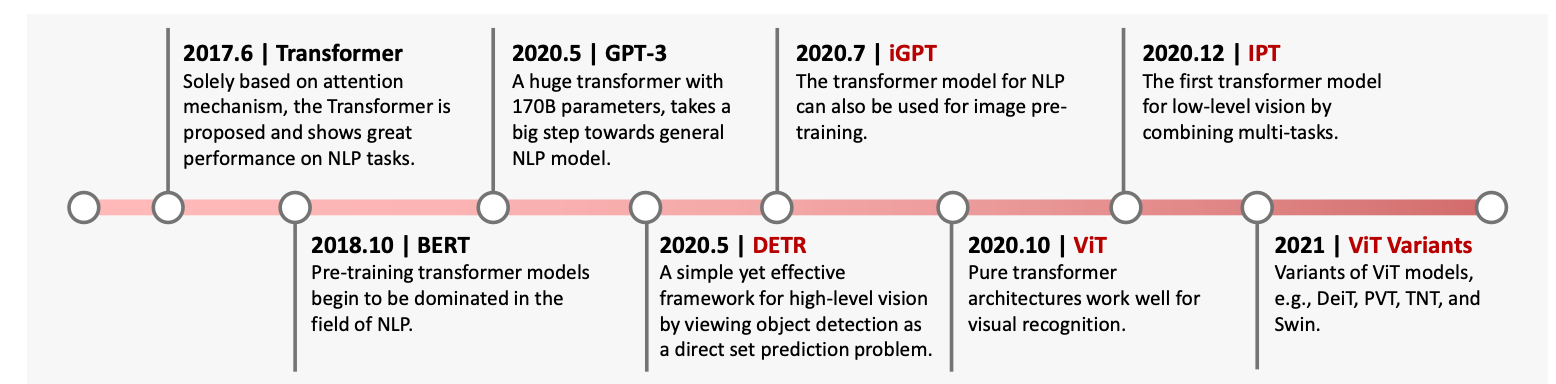

NIN(网络中的网络)

NIN(网络中的网络)

卷积层的输入和输出由四维张量组成,张量的每个轴分别对应样本、通道、高度和宽度。

另外,全连接层的输入和输出通常是分别对应于样本和特征的二维张量。

NiN 的想法是在每个像素位置(针对每个高度和宽度)应用一个全连接层。

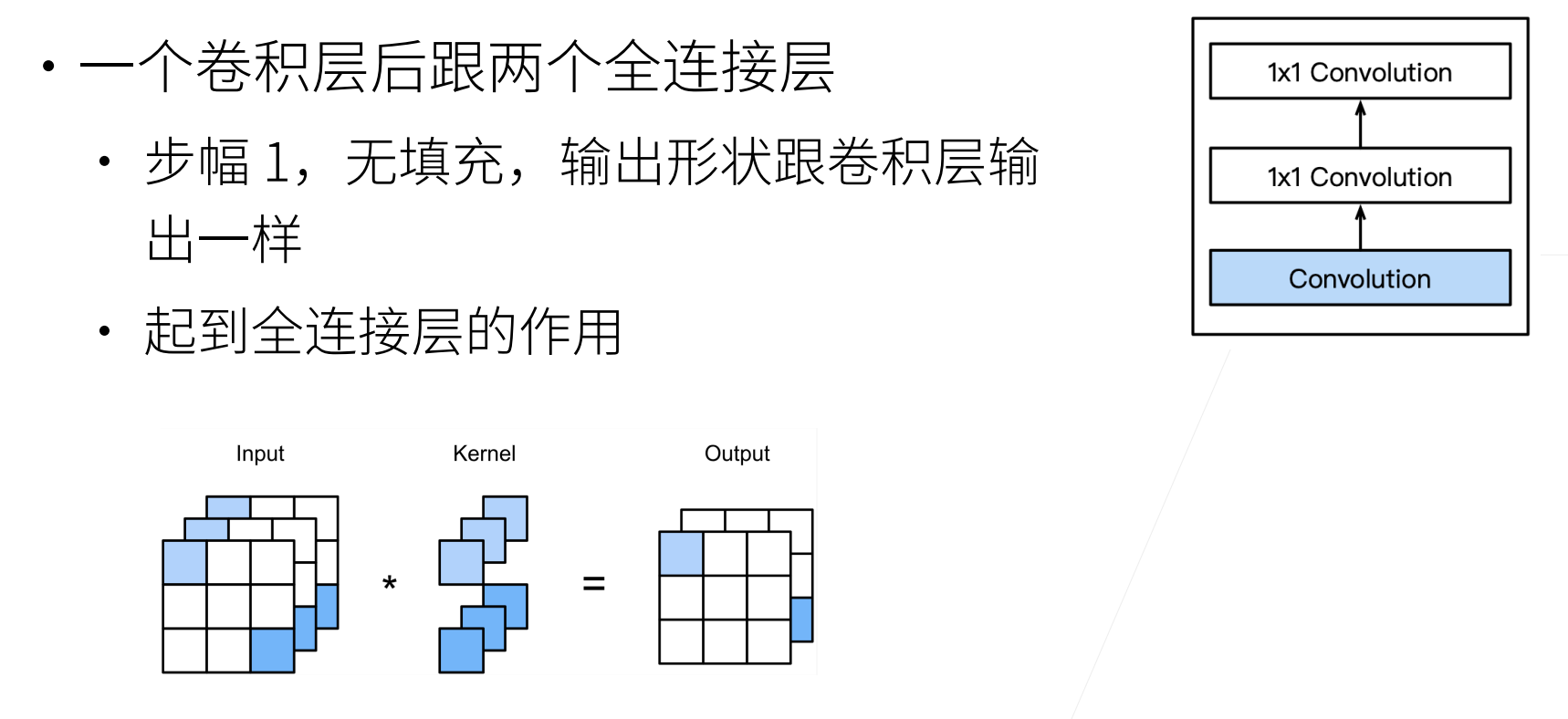

如果我们将权重连接到每个空间位置,我们可以将其视为 $1\times 1$ 卷积层(如 :numref:sec_channels 中所述),或作为在每个像素位置上独立作用的全连接层。

从另一个角度看,即将空间维度中的每个像素视为单个样本,将通道维度视为不同特征(feature)。

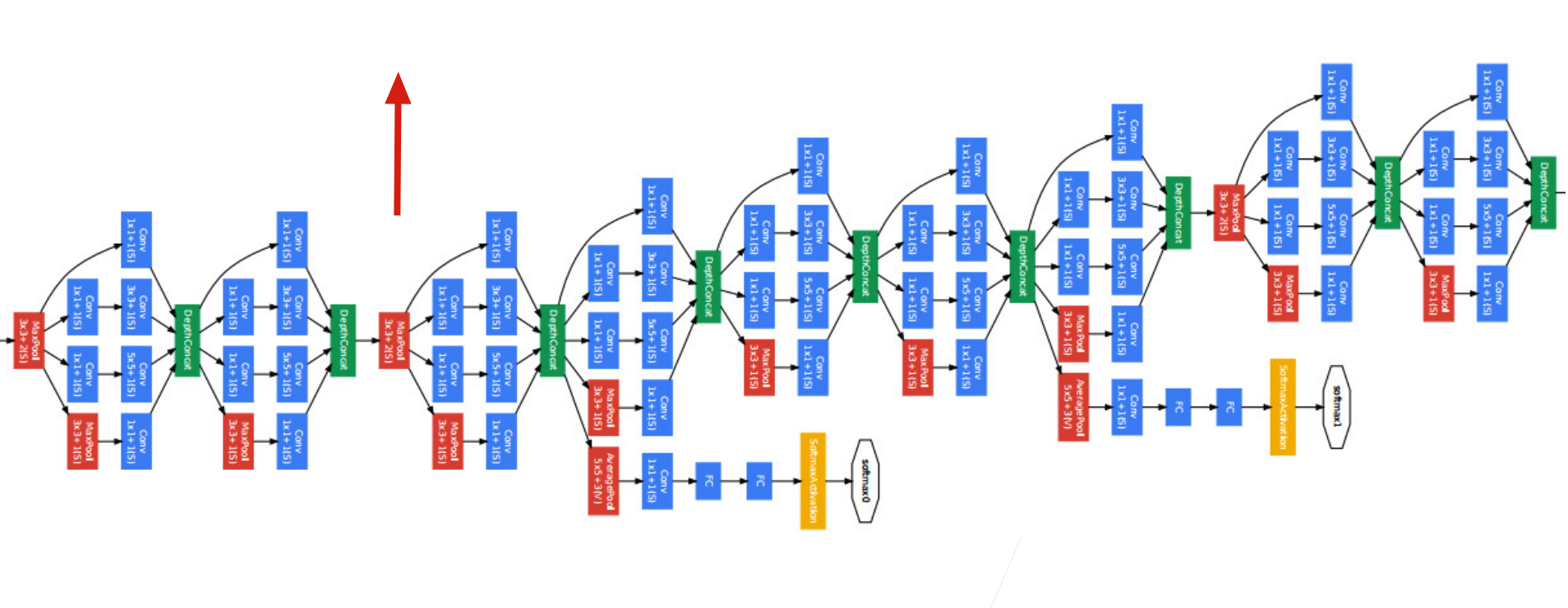

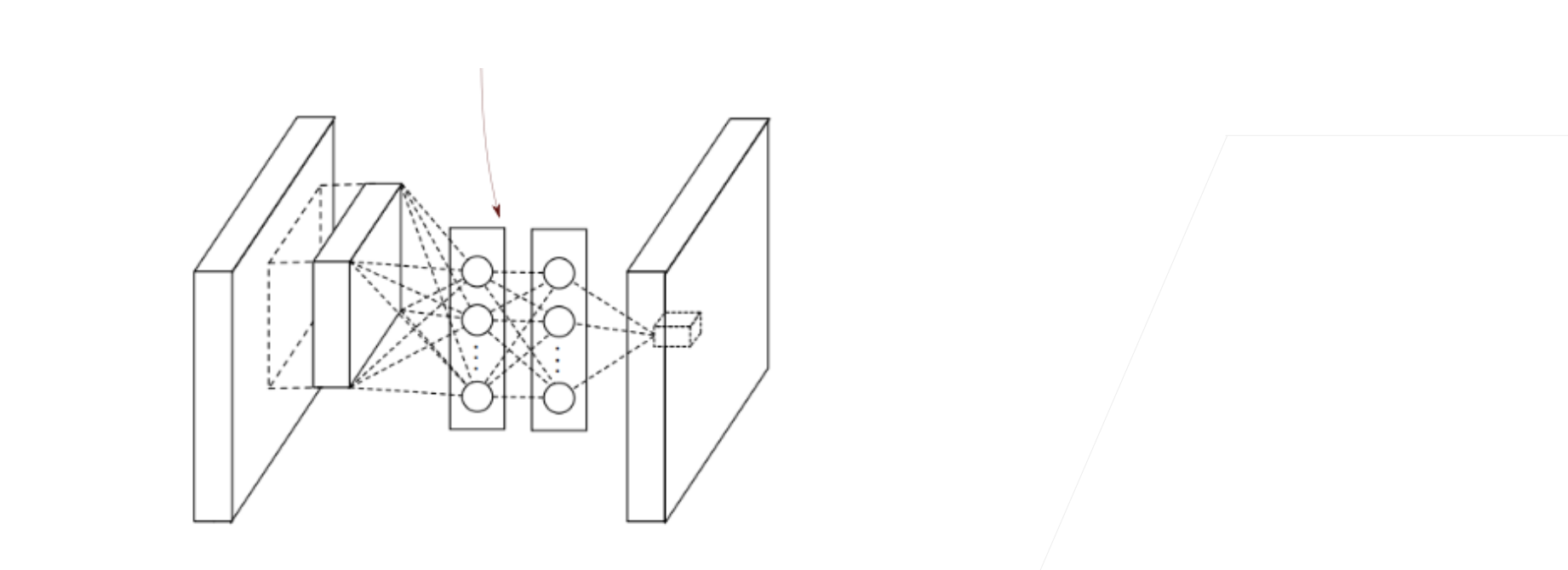

:numref:fig_nin 说明了 VGG 和 NiN 及它们的块之间主要结构差异。

NiN 块以一个普通卷积层开始,后面是两个 $1\times 1$ 的卷积层。这两个$1\times 1$ 卷积层充当带有 ReLU 激活函数的逐像素全连接层。

第一层的卷积窗口形状通常由用户设置。

随后的卷积窗口形状固定为 $1 \times 1$。

:width:600px

:label:fig_nin

import torch |

NiN模型(核心)

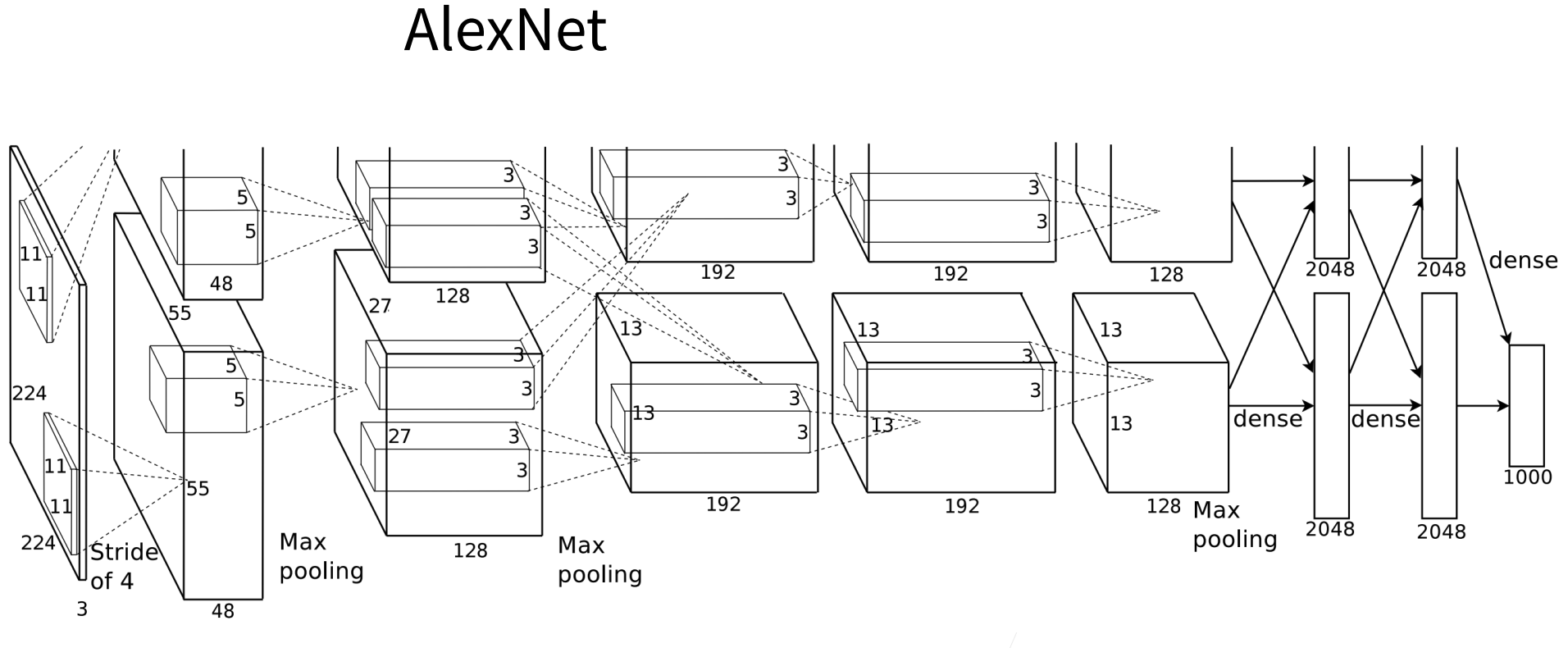

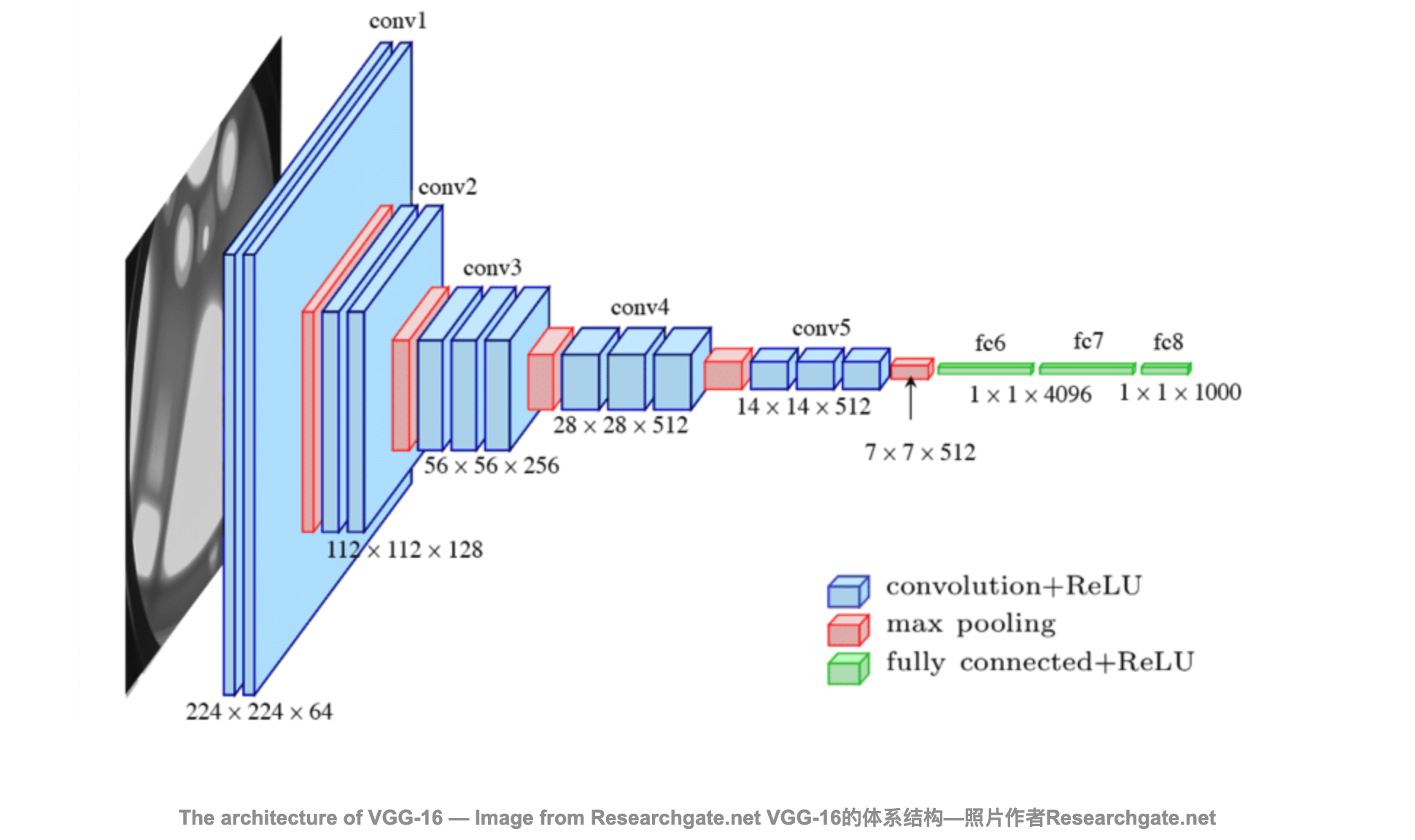

最初的 NiN 网络是在 AlexNet 后不久提出的,显然从中得到了一些启示。 NiN使用窗口形状为 11×11 、 5×5 和 3×3 的卷积层,输出通道数量与 AlexNet 中的相同。 每个 NiN 块后有一个最大汇聚层,池化窗口形状为 3×3 ,步幅为 2。

NiN 和 AlexNet 之间的一个显着区别是 NiN 完全取消了全连接层。 相反,NiN 使用一个 NiN块,其输出通道数等于标签类别的数量。最后放一个 全局平均汇聚层(global average pooling layer),生成一个多元逻辑向量(logits)。NiN 设计的一个优点是,它显著减少了模型所需参数的数量。然而,在实践中,这种设计有时会增加训练模型的时间。

net = nn.Sequential( |

查看每个块输出的形状

X = torch.rand(size=(1, 1, 224, 224)) |

Sequential output shape: torch.Size([1, 96, 54, 54])

MaxPool2d output shape: torch.Size([1, 96, 26, 26])

Sequential output shape: torch.Size([1, 256, 26, 26])

MaxPool2d output shape: torch.Size([1, 256, 12, 12])

Sequential output shape: torch.Size([1, 384, 12, 12])

MaxPool2d output shape: torch.Size([1, 384, 5, 5])

Dropout output shape: torch.Size([1, 384, 5, 5])

Sequential output shape: torch.Size([1, 10, 5, 5])

AdaptiveAvgPool2d output shape: torch.Size([1, 10, 1, 1])

Flatten output shape: torch.Size([1, 10])

/Users/baikal/miniforge3/envs/pytorch/lib/python3.8/site-packages/torch/nn/functional.py:718: UserWarning: Named tensors and all their associated APIs are an experimental feature and subject to change. Please do not use them for anything important until they are released as stable. (Triggered internally at ../c10/core/TensorImpl.h:1156.)

return torch.max_pool2d(input, kernel_size, stride, padding, dilation, ceil_mode)

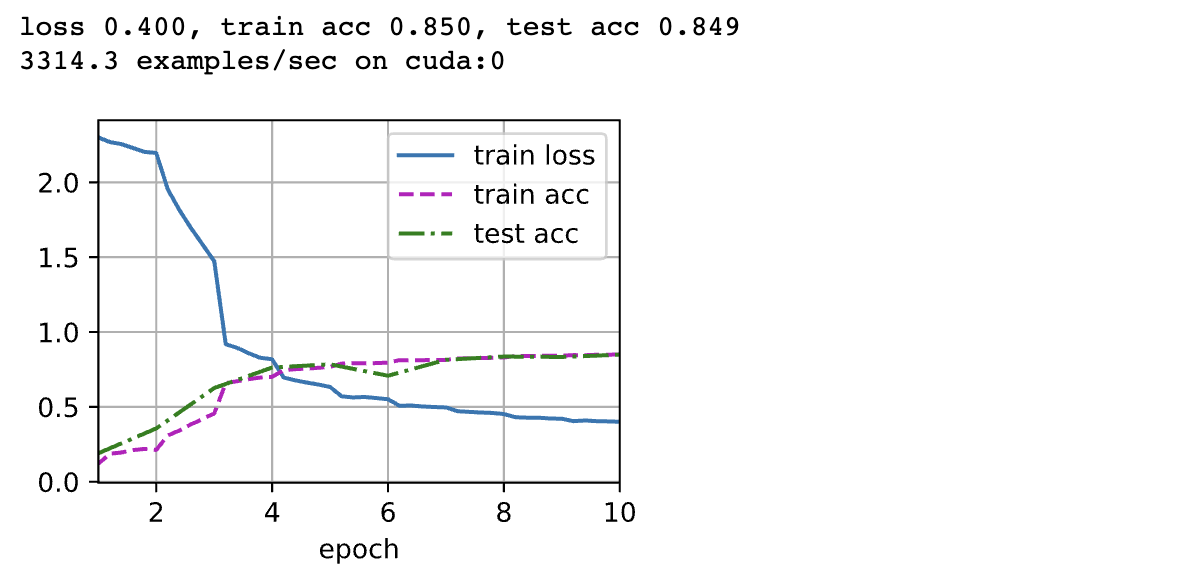

训练模型

lr, num_epochs, batch_size = 0.1, 10, 128 |

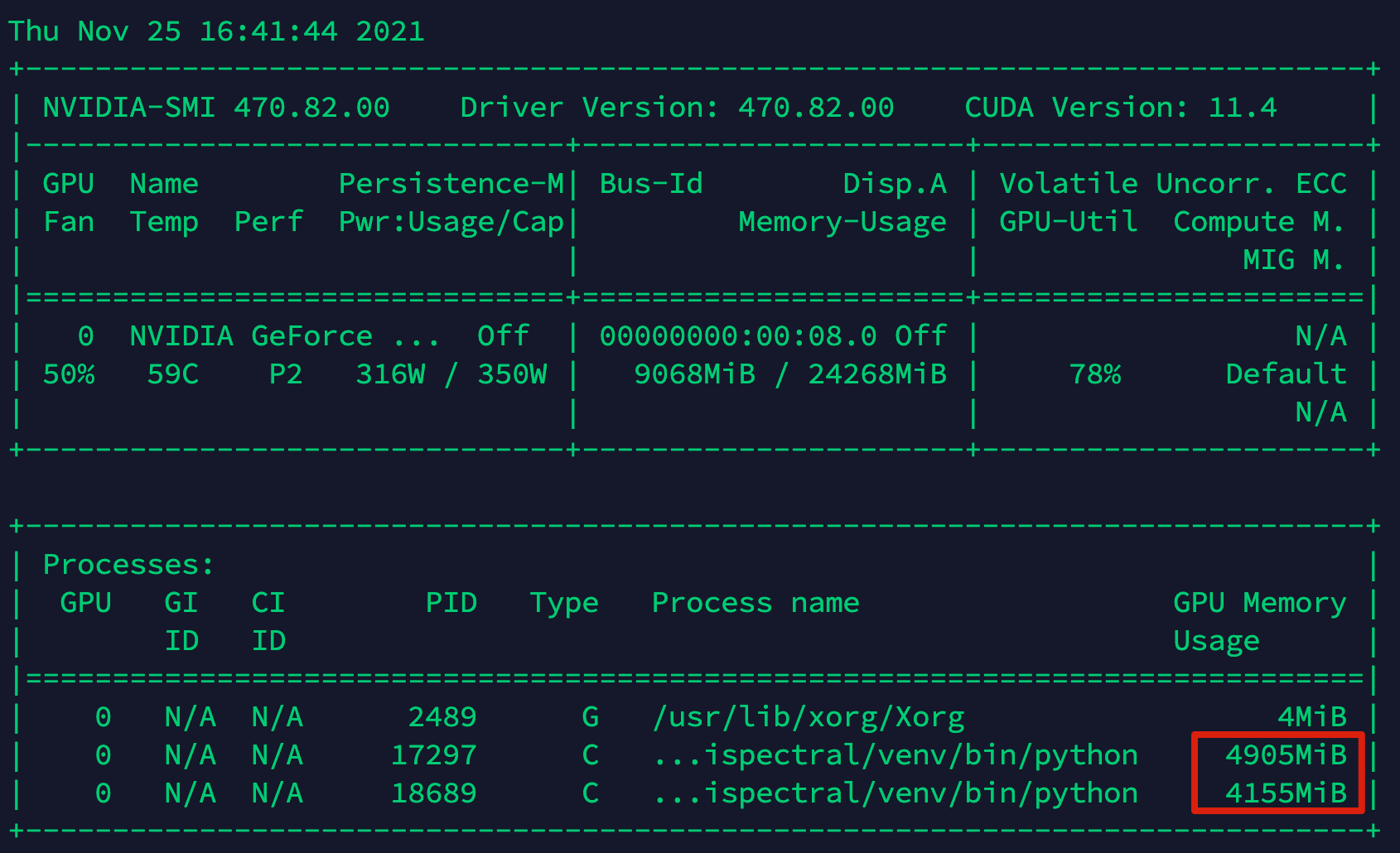

- 显存和GPU都被大量占用

小结

NiN使用由一个卷积层和多个 1×1 卷积层组成的块。该块可以在卷积神经网络中使用,以允许更多的每像素非线性。

NiN去除了容易造成过拟合的全连接层,将它们替换为全局平均汇聚层(即在所有位置上进行求和)。该汇聚层通道数量为所需的输出数量(例如,Fashion-MNIST的输出为10)。

移除全连接层可减少过拟合,同时显着减少NiN的参数。

NiN的设计影响了许多后续卷积神经网络的设计。